Im ersten Teil des Blog-Artikels zu RAG-Systemen haben wir uns mit den Grundlagen von RAG-Systemen beschäftigt. Doch man stößt bei diesen einfachen “Vanilla”-RAG-Systemen schnell an verschiedene Grenzen: Die Antworten werden zu langsam generiert oder deren Qualität ist nicht zufriedenstellend. Wie man diese Schwachstellen ausbessern kann wird im zweiten Artikel dieser Reihe behandelt. Doch wie immer gilt: bevor man mit der Optimierung beginnt, sollte man erst einmal feststellen, ob und wenn ja, wo überhaupt Optimierungsbedarf besteht.

Retrieval-Optimierung

Die Qualität eines Retrieval-Augmented Generation (RAG) Systems steht und fällt mit der Güte des Retrieval-Prozesses. Während das Grundprinzip – relevante Dokumente finden und an ein LLM weitergeben – simpel klingt, steckt der Teufel im Detail. In diesem Abschnitt betrachten wir, wie moderne RAG-Systeme ihre Retrieval-Pipeline optimieren, um präzisere und kontextreichere Ergebnisse zu liefern.

Der Retrieval-Prozess: Mehr als nur Suchen

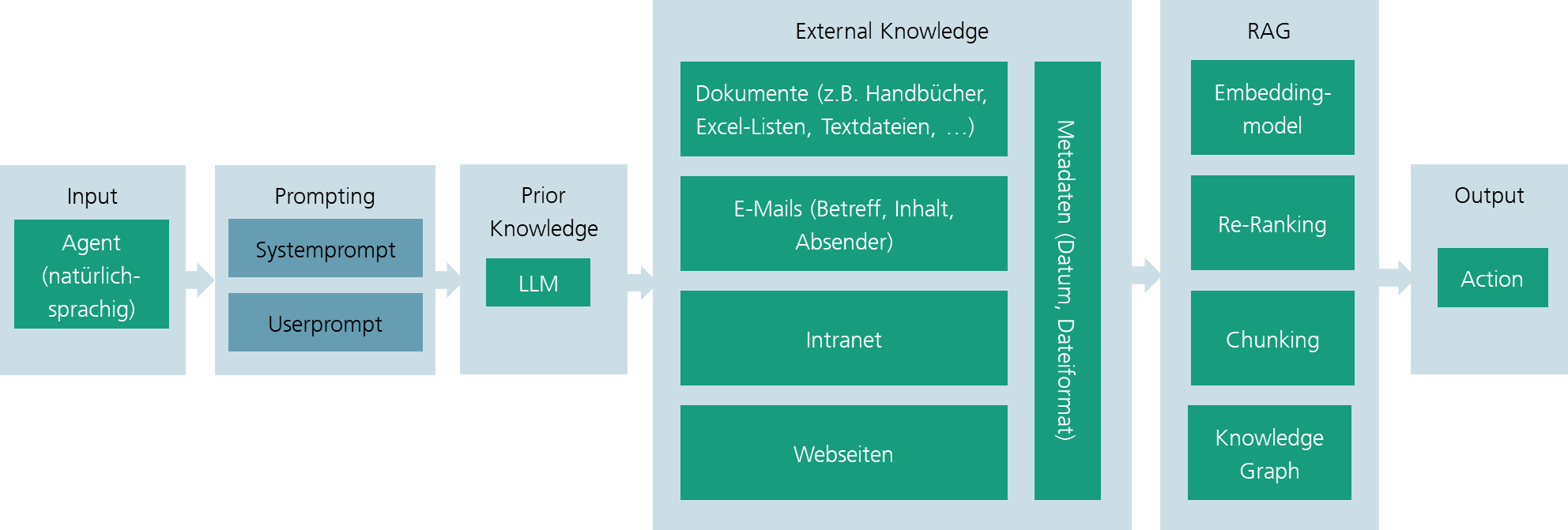

Wie in der Übersicht der Einleitung beschrieben, erfolgt der klassische Retrieval-Prozess in einem RAG-System mittels einer scheinbar einfachen Pipeline: Eine Nutzeranfrage wird mithilfe der Embedding-Funktion in einen Vektor eingebettet, gegen eine Vektordatenbank abgeglichen und die ähnlichsten Dokumente werden zurückgegeben. In der Praxis ist dieser Prozess jedoch wesentlich komplexer.

Ein typischer Ablauf beginnt mit der Anfrageverarbeitung, bei der die ursprüngliche Nutzeranfrage analysiert und möglicherweise umformuliert wird. Im zweiten Schritt wird die verarbeitete Anfrage durch Embedding-Generierung in einen hochdimensionalen Vektor transformiert. Die eigentliche Similarity Search findet dann mittels Ähnlichkeitssuche die ähnlichsten Dokumenten-Chunks. Nach diesem initialen Retrieval folgt eine Nachbearbeitungsphase, in der die gefundenen Dokumente gefiltert, neu gewichtet und sortiert werden. Abschließend werden im Context Assembly die finalen Dokumente für das LLM aufbereitet. Jeder dieser Schritte bietet erhebliches Optimierungspotenzial, das moderne Systeme systematisch ausschöpfen.

Abfrage und Nachbearbeitung: Die unterschätzten Stellschrauben

Query Preprocessing: Bevor eine Anfrage überhaupt die Vektordatenbank erreicht, lohnt sich oft eine Vorverarbeitung. Dabei können verschiedene Techniken zum Einsatz kommen. Die Normalisierung und Bereinigung durch Entfernung von Stoppwörtern, Stemming oder Lemmatisierung kann die Suchqualität verbessern, insbesondere wenn sie konsistent mit der Dokumenten-Indexierung durchgeführt wird. Stopp-Wörter sind dabei Wörter, die häufig auftreten, aber meist keine Relevanz für den Inhalt eines Textes haben, wie Artikel, Konjunktionen und Präpositionen. Stemming und Lemmatisierung bedeuten, dass Wörter auf ihren Wortstamm zurückgeführt werden, also z. B. konjugierte Werben auf ihren Verbstamm, entweder mit einem einfachen „Beschneiden“ des Wortes (Stemmings) oder unter Zuhilfenahme linguistischen Wissens (Lemmatisierung).

Post-Retrieval Processing: Nach dem initialen Retrieval beginnt die eigentliche Optimierungsarbeit. Die naive Annahme, dass die Top-k Ergebnisse einer Vektorsuche optimal sind, trifft in der Praxis selten zu. Deduplikation ist dabei ein wichtiger erster Schritt. Sehr ähnliche oder gar redundante Chunks sollten identifiziert und entfernt werden, was besonders wichtig ist, wenn das gleiche Dokument in mehreren Versionen vorliegt oder an verschiedenen Stellen ähnliche Informationen enthält. Zusätzliche Filterkriterien wie Dokumenttyp, Aktualität oder Autorität können durch Metadata-Filtering erst nach dem initialen Retrieval angewendet werden, um die Vektorsuche nicht zu verkomplizieren. Entscheidend ist auch das Context Window Management, denn die Reihenfolge der Dokumente im finalen Prompt spielt eine wichtige Rolle. Studien zeigen, dass LLMs häufig Informationen am Anfang oder Ende des Kontexts stärker gewichten, ein Phänomen, das als „lost in the middle“-Effekt bekannt ist.

Advanced Retrieval-Techniken: State of the Art

Hybride Suche – Das Beste aus beiden Welten: Pure Vektorsuche hat einen fundamentalen Nachteil: Sie findet semantisch ähnliche Inhalte, kann aber bei exakten Begriffen oder Namen versagen. Umgekehrt liefert klassische Keyword-Suche (z.B. BM25) bei exakten Matches hervorragende Ergebnisse, scheitert aber an semantischen Variationen.

Hybride Suche kombiniert beide Ansätze durch Berechnung eines hybriden Scores: score_hybrid = α * score_semantic + (1 – α) * score_keyword. Der Parameter α (typischerweise 0,5–0,7) steuert die Gewichtung. In der Praxis kombiniert dieser Ansatz die Stärken beider Methoden: Die Keyword-Komponente auf Basis von BM25 findet exakte Terme und Namen zuverlässig, während die semantische Komponente konzeptuelle Ähnlichkeit und Paraphrasen erfasst. Moderne Implementierungen verwenden oft Reciprocal Rank Fusion (RRF), um die Rankings beider Methoden zu kombinieren: 𝑅𝑅𝐹𝑆𝑐𝑜𝑟𝑒 = ⍁1𝑘 + (rank_method(d)

Dies ist robuster gegenüber unterschiedlichen Score-Skalen als eine simple lineare Kombination. Bei technischer Dokumentation oder Codesuche sollte die Keyword-Komponente stärker gewichtet werden (α ≈ 0,4), bei konzeptionellen Fragen die semantische Suche (α ≈ 0,7).

Re-Ranking – Die zweite Meinung: Das initiale Retrieval muss schnell sein und arbeitet daher oft mit einfacheren Embeddings oder approximativen Nearest-Neighbor-Verfahren. Re-Ranking nutzt diese Effizienz aus, indem es nur die Top-k Kandidaten (typisch 20–100) mit aufwändigeren Modellen neu bewertet. Das bedeutet, für diese werden genauer auf Passfähigkeit für die Anfrage gewertet und neu sortiert. Hierbei kommen Encode zum Einsatz. Im Gegensatz zu Bi-Encodern (die Query und Dokument separat embedden) verarbeiten Cross-Encoder beide gemeinsam. Dies erlaubt komplexere Interaktionen (Attention über Query-Document-Paare), ist aber zu langsam für die initiale Suche über Millionen von Dokumenten. Typische Architekturen für Re-Ranking umfassen MiniLM-basierte Re-Ranker, die schnell und effizient für Produktivsysteme sind, BERT-large Cross-Encoder mit höherer Qualität, aber auch höherer Latenz, sowie spezialisierte Modelle wie Mono-T5 oder RankGPT, das auf LLMs basiert. Eine effektive Implementierungsstrategie arbeitet mehrstufig: Im ersten Schritt nutzt ein Bi-Encoder für das initiale Retrieval etwa 1000 Kandidaten aus Millionen von Dokumenten in unter 100 Millisekunden. Anschließend erfolgt ein Cross-Encoder Re-Ranking, das die Top 50 aus diesen 1000 Kandidaten in weniger als 500 Millisekunden identifiziert. Optional kann ein weiteres Re-Ranking mit einem noch stärkeren Modell auf die finalen Top 10 angewendet werden.

Query Expansion und Reformulierung: Mehr Perspektiven

Nutzeranfragen sind oft unpräzise, zu kurz oder verwenden nicht die Terminologie des Dokumentenkorpus. Die Methoden Query Expansion adressiert dieses Problem systematisch. Klassische Ansätze zur Query Expansion nutzen Pseudo-Relevance Feedback, bei dem Terme aus den Top-k Ergebnissen einer ersten Suche für eine zweite, erweiterte Suche verwendet werden. Ein anderer etablierter Ansatz ist die Synonym-Expansion, die bekannte Synonyme hinzufügt, etwa über WordNet oder domänenspezifische Ontologien.

LLM-basierte Query Reformulierung: Moderne Systeme nutzen LLMs, um Anfragen zu erweitern oder zu präzisieren. Multi-Query Retrieval verfolgt einen anderen Ansatz: Statt eine perfekte Query zu formulieren, werden mehrere Varianten generiert und parallele Suchen durchgeführt. Aus der ursprünglichen Frage „Wie reduziere ich Memory-Verbrauch?“ könnten beispielsweise Varianten wie „Memory-Optimierung Best Practices“, „RAM-Nutzung senken Techniken“ oder „Speicherlecks vermeiden Strategien“ entstehen. Die Ergebnisse werden anschließend aggregiert und dedupliziert.

MMR: Relevanz trifft Diversität Ein oft übersehenes Problem: Die Top-k Ergebnisse einer Vektorsuche sind sich oft sehr ähnlich – es wurden im Rahmen der hybriden Suche ja nur die passendsten, im Sinne von ähnlichsten, Chunks zu der Suchanfrage selektiert. Für umfassende Antworten ist jedoch auch ein gewisses Maß an Diversität wünschenswert. Maximal Marginal Relevance (MMR) optimiert explizit für beide Ziele. Das bedeutet, MMR wählt das Dokument, das gleichzeitig relevant zur Query und unähnlich zu bereits gewählten Dokumenten ist.

Praktisches Beispiel: Bei der Suche nach „Python Web Frameworks“ würde ein reines Similarity-Ranking möglicherweise 5 Django-Tutorials zurückgeben. MMR würde stattdessen je ein Dokument zu Django, Flask, FastAPI, Tornado und Pyramid liefern – deutlich informativer für eine umfassende Übersicht. Implementierungsvarianten für MMR umfassen den Greedy-MMR-Ansatz, der iterativ das beste Dokument nach obiger Formel wählt, Cluster-based Selection, bei dem zunächst Kandidaten geclustert und dann aus jedem Cluster ausgewählt werden, sowie Submodular Optimization, die die Submodularität für bessere Approximationen nutzt. Die Entscheidung, wann MMR eingesetzt werden sollte, hängt stark vom Anwendungsfall ab. Besonders geeignet ist MMR für explorative Suchen mit Anfragen wie „Überblick über X“, für Multi-Aspekt-Fragen etwa zu Vor- und Nachteilen, sowie zur Vermeidung von Echo Chambers in Zusammenfassungen. Weniger sinnvoll ist der Einsatz von MMR hingegen bei spezifischen Fragen mit eindeutiger Antwort, wenn alle relevanten Aspekte bereits im gleichen Dokument stehen, oder bei sehr kleinen Retrieval-Sets mit weniger als fünf Dokumenten.

Best Practices und Implementierungshinweise: Bei der Implementierung dieser Techniken sollten mehrere Aspekte beachtet werden. Es empfiehlt sich, nicht alles auf einmal umzusetzen, sondern mit Hybrid Search zu starten, dann Re-Ranking hinzuzufügen und zuletzt mit Query Expansion zu experimentieren, da jede Technik Latenzkosten verursacht. Messung ist dabei essenziell: Klare Metriken wie Recall@k, MRR oder NDCG sollten definiert und systematisch evaluiert werden, da subjektive Eindrücke oft täuschen. Domänenspezifische Anpassung ist ebenfalls wichtig – ein α von 0.5 für Hybrid Search ist ein Startpunkt, kein Dogma, und sollte basierend auf den eigenen Daten optimiert werden. Caching sollte strategisch eingesetzt werden, da Re-Ranking teuer ist und Ergebnisse für häufige Queries gecacht werden sollten. Schließlich ist auch Monitoring im Produktivbetrieb entscheidend: Die Retrieval-Qualität sollte kontinuierlich überwacht werden, da Distribution Shifts in Nutzeranfragen die Modellperformance degradieren können.

image2

Abbildung 1: Bestandteile eines RAGs

Praxisbeispiele und Use Cases

1. Unternehmensinternes Wissensmanagement

Mitarbeitende können Fragen zu internen Richtlinien, Prozessen oder Projekten stellen. Das System durchsucht automatisch Intranets, Confluence-Seiten, Dokumente, Tabellen und E-Mails und liefert präzise, kontextbezogene Antworten. Ein konkretes Beispiel sind RAG-basierte Chatbots für Support- oder HR-Abteilungen.

2. Medizinische Dokumentation

Ärztinnen und Ärzte oder Forschende können auf aktuelle Fachartikel, Leitlinien und Patientendaten zugreifen. Das System liefert evidenzbasierte Antworten oder Zusammenfassungen, ohne Patientendaten an externe Modelle weiterzugeben. Die Quellen zu den Dokumenten werden angegeben.

3. Juristische und regulatorische Recherche:

In Kanzleien oder Behörden können RAG-Systeme Gesetze, Urteile oder interne Kommentierungen durchsuchen und juristisch fundierte Zusammenfassungen generieren. Vorteil ist die Verringerung von Halluzinationen, da die Inhalte domänenspezifisch an hinterlegte Vorschriften und Regularien angepasst sind.

Abfrage der Informationen und deren Kontext

Context-Window-Management

- (Intelligente Kontext-Selektion und –Priorisierung)

- Token-Effzienzienz-Optimierung

- Hierarchisches Context-Loading

Prompt-Engineering für RAG

- Strukturierung von Retrieved Context im Prompt

- Instruktionen zur Quellennutzung

- Citation und Halluzination-Reduktion

Performance- und Qualitätsoptimierung

Ein RAG-System mag in der Theorie elegant wirken, doch der Weg von einem Proof-of-Concept zu einem produktionsreifen System ist steinig. Zwei zentrale Herausforderungen dominieren diese Reise: Die Latenz muss niedrig genug sein, um eine gute User Experience zu gewährleisten, und die Qualität muss konsistent hoch bleiben. In diesem Abschnitt betrachten wir bewährte Strategien zur Performance-Optimierung sowie systematische Ansätze zur Qualitätssicherung, die den Unterschied zwischen einem nur exemplarisch funktionierenden Prototyp und einem robusten Produktivsystem ausmachen. Eine Vorbemerkung vorab: bei der Optimierung sollte der Grundsatz “premature optimization is the root of all evil” beachtet werden. Man sollte also erst optimieren, wenn sich zeigt dass dies notwendig ist und man durch Benchmarking herausgefunden hat, wo Ansatzpunkte für die Optimierung sind.

Caching als Grundlage der Latenzoptimierung

Die Latenz eines RAG-Systems setzt sich, entsprechend der Stufen der oben beschrieben Pipeline die bei einer Anfrage ausgeführt wird, aus mehreren Komponenten zusammen: Embedding-Generierung für die Query, Vektorsuche in der Datenbank, optionales Re-Ranking, Context Assembly und schließlich die LLM-Inferenz. Während die LLM-Inferenz oft den größten Teil der Gesamtlatenz ausmacht, hat man darauf meist nur einen geringen Einfluss. Glücklicherweise bietet auch die Retrieval-Pipeline erhebliches Optimierungspotenzial, das häufig unterschätzt wird. Caching ist eine der effektivsten Methoden zur Latenzreduktion, wenn sie intelligent eingesetzt wird. RAG-Systeme bieten mehrere Ebenen, auf denen Caching greifen kann, wobei jede Ebene unterschiedliche Trade-offs zwischen Cache-Hit-Rate, Speicherverbrauch und Aktualitätsgarantien mit sich bringt.

Der Embedding-Cache ist die erste und oft effektivste Caching-Ebene. Das Embedding-Modell transformiert Text in hochdimensionale Vektoren, ein Prozess der je nach Modellgröße zwischen 10 und 100 Millisekunden pro Query dauern kann. Bei Nutzeranfragen, die sich semantisch ähneln oder wiederholen, lässt sich diese Zeit komplett einsparen. Der Cache-Key sollte dabei nicht der Raw-Text sein, sondern ein normalisierter Hash, der Groß-/Kleinschreibung, Whitespace-Variationen und triviale Umformulierungen berücksichtigt. Eine einfache Implementierung könnte folgendermaßen aussehen: Der Text wird zunächst in Reine Kleinbuchstaben konvertiert werden, dann werden Sonderzeichen entfernt und der “Whitespace” also Steuerzeichen, Tabulatoren, und Umbrüche normalisiert. Anschließend wird ein SHA-256 Hash berechnet, der als Cache-Key dient. Der eigentliche Embedding-Vektor wird dann mit diesem Key in einem Key-Value-Store wie Redis oder einem In-Memory-Cache gespeichert. Die Cache-Hit-Rate hängt stark vom Anwendungsfall ab. Bei FAQ-Systemen oder Dokumentationssuchen, wo Nutzer ähnliche Fragen stellen, sind Raten von 30-50% realistisch. In explorativen Research-Szenarien mit hochvariablen Queries sinkt die Rate auf unter 10%. Ein wichtiger Parameter ist die Time-To-Live, die das Trade-off zwischen Speicherverbrauch und Aktualität steuert. Für Embedding-Caches sind TTLs von mehreren Stunden bis Tagen sinnvoll, da sich die semantische Bedeutung von Queries selten ändert und Embedding-Modelle in Produktion stabil bleiben.

Ein Query-Cache operiert auf einer höheren Ebene und speichert die kompletten Retrieval-Ergebnisse einer Query. Dies ist besonders wertvoll, da nicht nur das Embedding, sondern auch die teure Vektorsuche und eventuelle Re-Ranking-Schritte übersprungen werden können. Die Herausforderung liegt hier in der Cache-Invalidierung: Wenn sich der Dokumentenindex ändert, müssen betroffene Cache-Einträge invalidiert werden. Eine pragmatische Strategie arbeitet mit zwei Ansätzen parallel. Für häufige, stabile Queries wird ein Long-Term-Cache mit expliziter Invalidierung bei Index-Updates verwendet. Für weniger häufigen Queries greift ein Short-Term-Cache mit sehr kurzer TTL von nur wenigen Minuten, der automatisch abläuft.

Die Cache-Granularität ist ein weiterer wichtiger Aspekt. Soll nur die Liste der Top-k Dokument-IDs gecacht werden oder der komplette Text der Dokumente? Letzteres verbraucht mehr Speicher, spart aber zusätzliche Datenbankzugriffe. In der Praxis hat sich ein hybrider Ansatz bewährt: Die Top-3 bis Top-5 Dokumente werden vollständig gecacht, für Dokumente mit niedrigerem Rang nur die IDs. Dies basiert auf der Beobachtung, dass LLMs primär die ersten Dokumente im Context nutzen und spätere Dokumente seltener relevant sind.

Ein Response-Cache speichert die finalen LLM-Antworten und bietet das größte Latenzeinsparpotenzial. Hier muss jedoch besonders sorgfältig abgewogen werden, wann Caching sinnvoll ist. Für deterministische Fragen mit stabilen Antworten, etwa „Was ist die Hauptstadt von Frankreich?“, ist Response-Caching ideal. Bei kontextabhängigen oder zeitkritischen Fragen hingegen kann es zu veralteten oder inkonsistenten Antworten führen. Eine bewährte Strategie nutzt Semantic Similarity für den Cache-Lookup: Statt exakter String-Matches wird die Embedding-Ähnlichkeit zwischen der aktuellen Query und gecachten Queries berechnet. Überschreitet die Ähnlichkeit einen Threshold von beispielsweise 0.95, wird die gecachte Antwort zurückgegeben. Dies erhöht die Hit-Rate erheblich, erfordert aber zusätzliche Embedding-Berechnungen für den Cache-Lookup selbst.

Ein oft übersehener Aspekt ist das Cache-Warming: Bei Systemstart oder nach Index-Updates sollten häufige Queries proaktiv gecacht werden. Dies kann durch Analyse historischer Query-Logs geschehen, wo die Top-100 häufigsten Queries identifiziert und im Hintergrund vorberechnet werden. Für Produktivsysteme mit vorhersehbaren Traffic-Mustern, etwa morgendlichen Spitzen, kann das Warming zeitgesteuert vor erwarteten Load-Peaks erfolgen.

Asynchrone Retrieval-Pipelines: Parallelität als Schlüssel

Während Caching Wiederholungen eliminiert, adressiert Asynchronität die inhärente Struktur der Retrieval-Pipeline. Viele Schritte in einem RAG-System sind unabhängig voneinander und können parallel ausgeführt werden, was die Gesamtlatenz signifikant reduziert.

Betrachten wir eine typische erweiterte Retrieval-Pipeline: Multi-Query-Retrieval generiert drei Query-Varianten, für jede Variante wird sowohl eine semantische als auch eine Keyword-Suche durchgeführt, anschließend erfolgt Re-Ranking. In einem naiven, synchronen Ablauf würden diese Schritte sequenziell ausgeführt, mit einer Gesamtlatenz von möglicherweise 800 Millisekunden. Eine asynchrone Implementierung kann diese Zeit drastisch reduzieren.

Der erste Optimierungsschritt parallelisiert die Query-Generierung und das initiale Retrieval. Die drei Query-Varianten können durch das LLM in einem einzigen Batch-Request generiert werden, was die Netzwerk-Latenz reduziert. Sobald die Varianten vorliegen, können alle sechs Suchvorgänge, drei semantische und drei Keyword-basierte, parallel gegen die Datenbank ausgeführt werden. In Python lässt sich dies elegant mit asyncio umsetzen, wobei jede Suche als Coroutine formuliert wird und alle Coroutines mit asyncio.gather gleichzeitig gestartet werden.

Die eigentliche Herausforderung liegt im Re-Ranking. Klassischerweise würde man warten, bis alle Retrieval-Ergebnisse vorliegen, diese mergen und dann re-ranken. Ein ausgeklügelterer Ansatz nutzt Progressive Re-Ranking: Sobald die ersten Retrieval-Ergebnisse eintreffen, beginnt ein Hintergrund-Thread mit dem Re-Ranking dieser Teilergebnisse. Wenn weitere Ergebnisse ankommen, werden sie inkrementell in das Ranking integriert. Dies reduziert die Idle-Zeit und ermöglicht, dass das Re-Ranking-Modell kontinuierlich arbeitet, statt auf einen großen Batch zu warten.

Für WebSocket-basierte Systeme oder Streaming-Interfaces bietet sich Streaming Retrieval an. Statt zu warten, bis alle Dokumente ranked sind, werden die Top-Kandidaten schrittweise an das LLM gestreamt. Das LLM kann bereits mit der Generierung beginnen, während im Hintergrund weitere Dokumente nachgereicht werden. Dies ist besonders effektiv, wenn das LLM selbst im Streaming-Modus arbeitet und Token-für-Token generiert. Der Nutzer erhält quasi-instantanes Feedback, während im Hintergrund die vollständige Retrieval-Pipeline noch läuft.

Ein kritischer Aspekt asynchroner Systeme ist das Error Handling. Bei parallelen Requests können einzelne Komponenten fehlschlagen, ohne dass das Gesamtsystem blockiert. Eine robuste Implementierung sollte Fallback-Strategien definieren: Wenn eine Query-Variante fehlschlägt, arbeitet das System mit den erfolgreichen Varianten weiter. Wenn das Re-Ranking einen Timeout erreicht, werden die ursprünglichen Retrieval-Rankings verwendet. Diese Graceful Degradation ist entscheidend für Produktionssysteme, wo Verfügbarkeit oft wichtiger ist als perfekte Qualität.

Batch-Processing-Optimierungen: Skalierung durch Gruppierung

Während asynchrone Pipelines einzelne Requests beschleunigen, adressiert Batch-Processing die Systemeffizienz bei hohem Durchsatz. Moderne Hardware, insbesondere GPUs, ist für Batch-Operationen optimiert und erreicht deutlich höhere Throughput-Raten, wenn mehrere Eingaben gleichzeitig verarbeitet werden. Die einfachste Form des Batching betrifft das Embedding-Modell. Statt Queries einzeln zu embedden, werden sie in einem Zeitfenster, typischerweise 10-50 Millisekunden, gesammelt und gemeinsam durch das Modell geschickt. Bei einem BERT-basierten Embedding-Modell kann der Durchsatz von etwa 100 Queries pro Sekunde bei Single-Request-Processing auf über 1000 Queries pro Sekunde bei Batch-Size 32 steigen. Dieser Faktor von 10x kommt durch bessere GPU-Auslastung und reduzierte Overhead-Kosten pro Request zustande. Dies ist aber nur bei hohem Traffic sinnvoll, d.h. wenn viele Anfragen zur selben Zeit eintreffen oder in kurzen Abständen eintreffen.

Die Herausforderung liegt im Trade-off zwischen Latenz und Throughput. Ein größeres Batch erhöht den Durchsatz, bedeutet aber auch, dass früh eintreffende Queries länger warten müssen, bis das Batch voll ist. Eine adaptive Batching-Strategie nutzt dynamische Timeouts: Bei niedrigem Traffic wird ein kurzes Timeout von 10 Millisekunden gesetzt, sodass Queries schnell verarbeitet werden. Bei hohem Traffic verlängert sich das Timeout auf 50 Millisekunden, um größere Batches zu bilden und den Durchsatz zu maximieren. Dies lässt sich implementieren, indem die aktuelle Queue-Länge kontinuierlich überwacht wird und das Timeout basierend auf einer Heuristik wie „Timeout = min(10ms + Queue-Length * 2ms, 50ms)“ angepasst wird.

Batch-Processing erstreckt sich auch auf die Vektorsuche selbst. Moderne Vektordatenbanken unterstützen Batch-Queries nativ. Statt 10 separate Suchen nacheinander auszuführen, kann ein einziger Batch-Request mit allen 10 Query-Vektoren geschickt werden. Die Datenbank kann dann Optimierungen auf Index-Ebene vornehmen, etwa durch Shared-Computations in HNSW-Graphen oder parallele Scans in inverted Indices.

Für das Re-Ranking-Modell ist Batching besonders kritisch, da Cross-Encoder erheblich teurer als Bi-Encoder sind. Wenn 100 Queries jeweils 20 Kandidaten re-ranken müssen, entstehen 2000 Query-Document-Paare. Diese in einem einzigen großen Batch durch den Cross-Encoder zu schicken, statt 100 separate Batches à 20 Paare, kann die Verarbeitungszeit um den Faktor 5-10 reduzieren. Allerdings muss darauf geachtet werden, dass die Batch-Size die GPU-Memory-Grenzen nicht überschreitet. Eine pragmatische Implementierung nutzt dynamisches Batching mit Backpressure: Wenn die GPU-Auslastung 90% überschreitet, werden neue Requests temporär gepuffert oder an Replicas weitergeleitet.

Ein fortgeschrittenes Konzept ist Speculative Batching für das LLM selbst. Während das LLM für eine Query generiert, können bereits die Retrieval-Ergebnisse für nachfolgende Queries vorbereitet werden. Wenn mehrere Queries denselben Kontext verwenden, etwa bei Follow-up-Fragen in einem Dialog, kann das LLM diese in einem einzigen Forward-Pass verarbeiten, wobei der geteilte Kontext nur einmal encodiert werden muss. Dies ist besonders effektiv bei Architekturen mit langen Prefill-Phasen wie bei großen Transformer-Modellen.

Abfrage der Informationen und deren Kontext

Context-Window-Management

- (Intelligente Kontext-Selektion und –Priorisierung)

- Token-Effzienzienz-Optimierung

- Hierarchisches Context-Loading

Prompt-Engineering für RAG

- Strukturierung von Retrieved Context im Prompt

- Instruktionen zur Quellennutzung

- Citation und Halluzination-Reduktion

Performance- und Qualitätsoptimierung

Ein RAG-System mag in der Theorie elegant wirken, doch der Weg von einem Proof-of-Concept zu einem produktionsreifen System ist steinig. Zwei zentrale Herausforderungen dominieren diese Reise: Die Latenz muss niedrig genug sein, um eine gute User Experience zu gewährleisten, und die Qualität muss konsistent hoch bleiben. In diesem Abschnitt betrachten wir bewährte Strategien zur Performance-Optimierung sowie systematische Ansätze zur Qualitätssicherung, die den Unterschied zwischen einem nur exemplarisch funktionierenden Prototyp und einem robusten Produktivsystem ausmachen. Eine Vorbemerkung vorab: bei der Optimierung sollte der Grundsatz “premature optimization is the root of all evil” beachtet werden. Man sollte also erst optimieren, wenn sich zeigt dass dies notwendig ist und man durch Benchmarking herausgefunden hat, wo Ansatzpunkte für die Optimierung sind.

Caching als Grundlage der Latenzoptimierung

Die Latenz eines RAG-Systems setzt sich, entsprechend der Stufen der oben beschrieben Pipeline die bei einer Anfrage ausgeführt wird, aus mehreren Komponenten zusammen: Embedding-Generierung für die Query, Vektorsuche in der Datenbank, optionales Re-Ranking, Context Assembly und schließlich die LLM-Inferenz. Während die LLM-Inferenz oft den größten Teil der Gesamtlatenz ausmacht, hat man darauf meist nur einen geringen Einfluss. Glücklicherweise bietet auch die Retrieval-Pipeline erhebliches Optimierungspotenzial, das häufig unterschätzt wird. Caching ist eine der effektivsten Methoden zur Latenzreduktion, wenn sie intelligent eingesetzt wird. RAG-Systeme bieten mehrere Ebenen, auf denen Caching greifen kann, wobei jede Ebene unterschiedliche Trade-offs zwischen Cache-Hit-Rate, Speicherverbrauch und Aktualitätsgarantien mit sich bringt.

Der Embedding-Cache ist die erste und oft effektivste Caching-Ebene. Das Embedding-Modell transformiert Text in hochdimensionale Vektoren, ein Prozess der je nach Modellgröße zwischen 10 und 100 Millisekunden pro Query dauern kann. Bei Nutzeranfragen, die sich semantisch ähneln oder wiederholen, lässt sich diese Zeit komplett einsparen. Der Cache-Key sollte dabei nicht der Raw-Text sein, sondern ein normalisierter Hash, der Groß-/Kleinschreibung, Whitespace-Variationen und triviale Umformulierungen berücksichtigt. Eine einfache Implementierung könnte folgendermaßen aussehen: Der Text wird zunächst in Reine Kleinbuchstaben konvertiert werden, dann werden Sonderzeichen entfernt und der “Whitespace” also Steuerzeichen, Tabulatoren, und Umbrüche normalisiert. Anschließend wird ein SHA-256 Hash berechnet, der als Cache-Key dient. Der eigentliche Embedding-Vektor wird dann mit diesem Key in einem Key-Value-Store wie Redis oder einem In-Memory-Cache gespeichert. Die Cache-Hit-Rate hängt stark vom Anwendungsfall ab. Bei FAQ-Systemen oder Dokumentationssuchen, wo Nutzer ähnliche Fragen stellen, sind Raten von 30-50% realistisch. In explorativen Research-Szenarien mit hochvariablen Queries sinkt die Rate auf unter 10%. Ein wichtiger Parameter ist die Time-To-Live, die das Trade-off zwischen Speicherverbrauch und Aktualität steuert. Für Embedding-Caches sind TTLs von mehreren Stunden bis Tagen sinnvoll, da sich die semantische Bedeutung von Queries selten ändert und Embedding-Modelle in Produktion stabil bleiben.

Ein Query-Cache operiert auf einer höheren Ebene und speichert die kompletten Retrieval-Ergebnisse einer Query. Dies ist besonders wertvoll, da nicht nur das Embedding, sondern auch die teure Vektorsuche und eventuelle Re-Ranking-Schritte übersprungen werden können. Die Herausforderung liegt hier in der Cache-Invalidierung: Wenn sich der Dokumentenindex ändert, müssen betroffene Cache-Einträge invalidiert werden. Eine pragmatische Strategie arbeitet mit zwei Ansätzen parallel. Für häufige, stabile Queries wird ein Long-Term-Cache mit expliziter Invalidierung bei Index-Updates verwendet. Für weniger häufigen Queries greift ein Short-Term-Cache mit sehr kurzer TTL von nur wenigen Minuten, der automatisch abläuft.

Die Cache-Granularität ist ein weiterer wichtiger Aspekt. Soll nur die Liste der Top-k Dokument-IDs gecacht werden oder der komplette Text der Dokumente? Letzteres verbraucht mehr Speicher, spart aber zusätzliche Datenbankzugriffe. In der Praxis hat sich ein hybrider Ansatz bewährt: Die Top-3 bis Top-5 Dokumente werden vollständig gecacht, für Dokumente mit niedrigerem Rang nur die IDs. Dies basiert auf der Beobachtung, dass LLMs primär die ersten Dokumente im Context nutzen und spätere Dokumente seltener relevant sind.

Ein Response-Cache speichert die finalen LLM-Antworten und bietet das größte Latenzeinsparpotenzial. Hier muss jedoch besonders sorgfältig abgewogen werden, wann Caching sinnvoll ist. Für deterministische Fragen mit stabilen Antworten, etwa „Was ist die Hauptstadt von Frankreich?“, ist Response-Caching ideal. Bei kontextabhängigen oder zeitkritischen Fragen hingegen kann es zu veralteten oder inkonsistenten Antworten führen. Eine bewährte Strategie nutzt Semantic Similarity für den Cache-Lookup: Statt exakter String-Matches wird die Embedding-Ähnlichkeit zwischen der aktuellen Query und gecachten Queries berechnet. Überschreitet die Ähnlichkeit einen Threshold von beispielsweise 0.95, wird die gecachte Antwort zurückgegeben. Dies erhöht die Hit-Rate erheblich, erfordert aber zusätzliche Embedding-Berechnungen für den Cache-Lookup selbst.

Ein oft übersehener Aspekt ist das Cache-Warming: Bei Systemstart oder nach Index-Updates sollten häufige Queries proaktiv gecacht werden. Dies kann durch Analyse historischer Query-Logs geschehen, wo die Top-100 häufigsten Queries identifiziert und im Hintergrund vorberechnet werden. Für Produktivsysteme mit vorhersehbaren Traffic-Mustern, etwa morgendlichen Spitzen, kann das Warming zeitgesteuert vor erwarteten Load-Peaks erfolgen.

Asynchrone Retrieval-Pipelines: Parallelität als Schlüssel

Während Caching Wiederholungen eliminiert, adressiert Asynchronität die inhärente Struktur der Retrieval-Pipeline. Viele Schritte in einem RAG-System sind unabhängig voneinander und können parallel ausgeführt werden, was die Gesamtlatenz signifikant reduziert.

Betrachten wir eine typische erweiterte Retrieval-Pipeline: Multi-Query-Retrieval generiert drei Query-Varianten, für jede Variante wird sowohl eine semantische als auch eine Keyword-Suche durchgeführt, anschließend erfolgt Re-Ranking. In einem naiven, synchronen Ablauf würden diese Schritte sequenziell ausgeführt, mit einer Gesamtlatenz von möglicherweise 800 Millisekunden. Eine asynchrone Implementierung kann diese Zeit drastisch reduzieren.

Der erste Optimierungsschritt parallelisiert die Query-Generierung und das initiale Retrieval. Die drei Query-Varianten können durch das LLM in einem einzigen Batch-Request generiert werden, was die Netzwerk-Latenz reduziert. Sobald die Varianten vorliegen, können alle sechs Suchvorgänge, drei semantische und drei Keyword-basierte, parallel gegen die Datenbank ausgeführt werden. In Python lässt sich dies elegant mit asyncio umsetzen, wobei jede Suche als Coroutine formuliert wird und alle Coroutines mit asyncio.gather gleichzeitig gestartet werden.

Die eigentliche Herausforderung liegt im Re-Ranking. Klassischerweise würde man warten, bis alle Retrieval-Ergebnisse vorliegen, diese mergen und dann re-ranken. Ein ausgeklügelterer Ansatz nutzt Progressive Re-Ranking: Sobald die ersten Retrieval-Ergebnisse eintreffen, beginnt ein Hintergrund-Thread mit dem Re-Ranking dieser Teilergebnisse. Wenn weitere Ergebnisse ankommen, werden sie inkrementell in das Ranking integriert. Dies reduziert die Idle-Zeit und ermöglicht, dass das Re-Ranking-Modell kontinuierlich arbeitet, statt auf einen großen Batch zu warten.

Für WebSocket-basierte Systeme oder Streaming-Interfaces bietet sich Streaming Retrieval an. Statt zu warten, bis alle Dokumente ranked sind, werden die Top-Kandidaten schrittweise an das LLM gestreamt. Das LLM kann bereits mit der Generierung beginnen, während im Hintergrund weitere Dokumente nachgereicht werden. Dies ist besonders effektiv, wenn das LLM selbst im Streaming-Modus arbeitet und Token-für-Token generiert. Der Nutzer erhält quasi-instantanes Feedback, während im Hintergrund die vollständige Retrieval-Pipeline noch läuft.

Ein kritischer Aspekt asynchroner Systeme ist das Error Handling. Bei parallelen Requests können einzelne Komponenten fehlschlagen, ohne dass das Gesamtsystem blockiert. Eine robuste Implementierung sollte Fallback-Strategien definieren: Wenn eine Query-Variante fehlschlägt, arbeitet das System mit den erfolgreichen Varianten weiter. Wenn das Re-Ranking einen Timeout erreicht, werden die ursprünglichen Retrieval-Rankings verwendet. Diese Graceful Degradation ist entscheidend für Produktionssysteme, wo Verfügbarkeit oft wichtiger ist als perfekte Qualität.

Batch-Processing-Optimierungen: Skalierung durch Gruppierung

Während asynchrone Pipelines einzelne Requests beschleunigen, adressiert Batch-Processing die Systemeffizienz bei hohem Durchsatz. Moderne Hardware, insbesondere GPUs, ist für Batch-Operationen optimiert und erreicht deutlich höhere Throughput-Raten, wenn mehrere Eingaben gleichzeitig verarbeitet werden. Die einfachste Form des Batching betrifft das Embedding-Modell. Statt Queries einzeln zu embedden, werden sie in einem Zeitfenster, typischerweise 10-50 Millisekunden, gesammelt und gemeinsam durch das Modell geschickt. Bei einem BERT-basierten Embedding-Modell kann der Durchsatz von etwa 100 Queries pro Sekunde bei Single-Request-Processing auf über 1000 Queries pro Sekunde bei Batch-Size 32 steigen. Dieser Faktor von 10x kommt durch bessere GPU-Auslastung und reduzierte Overhead-Kosten pro Request zustande. Dies ist aber nur bei hohem Traffic sinnvoll, d.h. wenn viele Anfragen zur selben Zeit eintreffen oder in kurzen Abständen eintreffen.

Die Herausforderung liegt im Trade-off zwischen Latenz und Throughput. Ein größeres Batch erhöht den Durchsatz, bedeutet aber auch, dass früh eintreffende Queries länger warten müssen, bis das Batch voll ist. Eine adaptive Batching-Strategie nutzt dynamische Timeouts: Bei niedrigem Traffic wird ein kurzes Timeout von 10 Millisekunden gesetzt, sodass Queries schnell verarbeitet werden. Bei hohem Traffic verlängert sich das Timeout auf 50 Millisekunden, um größere Batches zu bilden und den Durchsatz zu maximieren. Dies lässt sich implementieren, indem die aktuelle Queue-Länge kontinuierlich überwacht wird und das Timeout basierend auf einer Heuristik wie „Timeout = min(10ms + Queue-Length * 2ms, 50ms)“ angepasst wird.

Batch-Processing erstreckt sich auch auf die Vektorsuche selbst. Moderne Vektordatenbanken unterstützen Batch-Queries nativ. Statt 10 separate Suchen nacheinander auszuführen, kann ein einziger Batch-Request mit allen 10 Query-Vektoren geschickt werden. Die Datenbank kann dann Optimierungen auf Index-Ebene vornehmen, etwa durch Shared-Computations in HNSW-Graphen oder parallele Scans in inverted Indices.

Für das Re-Ranking-Modell ist Batching besonders kritisch, da Cross-Encoder erheblich teurer als Bi-Encoder sind. Wenn 100 Queries jeweils 20 Kandidaten re-ranken müssen, entstehen 2000 Query-Document-Paare. Diese in einem einzigen großen Batch durch den Cross-Encoder zu schicken, statt 100 separate Batches à 20 Paare, kann die Verarbeitungszeit um den Faktor 5-10 reduzieren. Allerdings muss darauf geachtet werden, dass die Batch-Size die GPU-Memory-Grenzen nicht überschreitet. Eine pragmatische Implementierung nutzt dynamisches Batching mit Backpressure: Wenn die GPU-Auslastung 90% überschreitet, werden neue Requests temporär gepuffert oder an Replicas weitergeleitet.

Ein fortgeschrittenes Konzept ist Speculative Batching für das LLM selbst. Während das LLM für eine Query generiert, können bereits die Retrieval-Ergebnisse für nachfolgende Queries vorbereitet werden. Wenn mehrere Queries denselben Kontext verwenden, etwa bei Follow-up-Fragen in einem Dialog, kann das LLM diese in einem einzigen Forward-Pass verarbeiten, wobei der geteilte Kontext nur einmal encodiert werden muss. Dies ist besonders effektiv bei Architekturen mit langen Prefill-Phasen wie bei großen Transformer-Modellen.